12.10

知识分子

The Intellectual

图源|Pexels

导 读

未来三五年内几乎一定会发生的事情是:社交媒体、短视频平台上开始大量出现普通人不容易分辨,完全由AI创作的“灌水”内容。这些内容既可以极大丰富社交媒体的内容厚度,还可以根据AI对人类兴趣爱好的学习追踪,为不同人群打造更为庞大、牢固的“信息茧房”。

撰文 | 王咏刚

责编 | 邸利会

● ● ●

近日,ChatGPT火遍了全网。人工智能研究和部署公司OpenAI 发布的短短5天内,就吸引了100万用户。在官方描述中,称其是一个“可以连续回答问题、承认自己的错误、挑战不正确的前提并拒绝不适当的要求”的对话模型。从闲聊、回答问题到写小说、诗歌,帮程序员解决程序的Bug等等,ChatGPT表现出的能力让不少人惊叹。

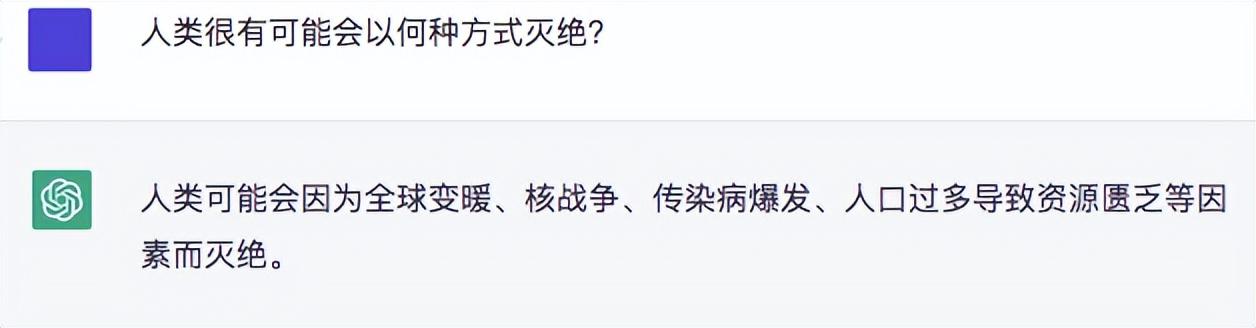

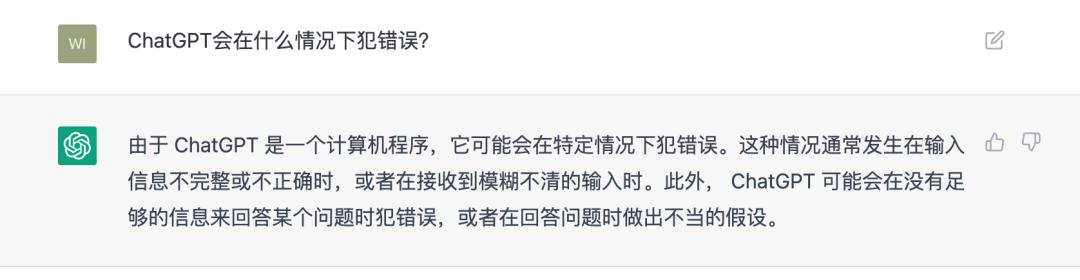

编者也忍不住尝试了一下,如下图。

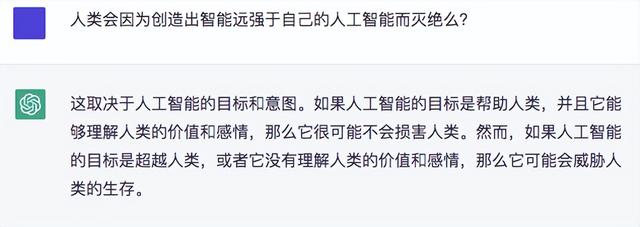

再比如,编者也想看看,它写诗的能力。

那么,在不少人看来,ChatGPT已经足够好了,但随之而来的问题是,它会不会被滥用产生危害?

带着一系列的问题,《知识分子》邀请创新工场人工智能工程院执行院长王咏刚带来他的解读。

01

ChatGPT是重大技术突破吗?

简单回答,不是根本性的突破。

OpenAI的ChatGPT是“现象级”技术创新,但不是根本性的科研或工程突破。最近几年AI生成内容(AIGC)突飞猛进,其中最为革命性的突破包括2017年提出的Transformer模型,2020年OpenAI发布的GPT-3,以及2022年替代GAN成为图像、视频生成主力的Diffusion模型家族。

ChatGPT是基于GPT-3的进一步创新,是站在巨人肩膀上的明星技术。简单说,ChatGPT是OpenAI原创性自动问答系统InstructGPT的延续,建立在GPT-3的后续改进版本GPT-3.5基础上,通过引入强化学习模型,大幅提高了AI在人机对话时的准确度和可控性。

非专业人士可以这样理解——OpenAI在2020年发布的GPT-3让计算机第一次拥有了惟妙惟肖模仿人类“说话”的能力,但此时的AI就像一个童言无忌的孩子,啥都会说,也啥都不顾忌。GPT-3生成的文字内容经常脑洞大开,观点和逻辑跨度好比天马行空,甚至屡屡输出错误观点、车轱辘话、脏字脏话。很显然,聪明但不懂事的“孩子”需要严加管教。

OpenAI引入了人类监督员,专门“教”AI如何更好地回答人类问题。AI的回答符合人类评价标准时,就给AI打高分,否则就给AI打低分。基于人类监督员的评价,OpenAI围绕GPT-3.5打造了一个强化学习模型,督促AI按照人类价值观优化数据和参数,最终开发出效果惊艳,火爆出圈的ChatGPT。

02

如何看待ChatGPT?

概言之,我的感觉是,喜忧参半。

喜的是,依靠“暴力”学习几乎所有人类知识内容,建立无比复杂、庞大的神经网络,这条让AI越来越“聪明”的路看来还能继续走下去。GPT-3有1750亿个参数用于“记忆”和“提炼”人类知识的规律,很快就要问世的下一代模型GPT-4据说拥有远超GPT-3的复杂度。

像ChatGPT一样为这条路增加少量强化学习元素,更是能起到画龙点睛的作用,将AI在应用领域的潜力充分激活。超大模型,强化学习,领域优化——这三件事可能意味着,AI在未来几年内比以前任何时候都更容易深入人类各个应用场景,真正承担起许多原本只有人类能完成的一些工作。

忧的是,今天的超大规模AI模型依然具备科研“黑盒子”的典型特征。

科学家和工程师知道如何建立这个“黑盒子”,但无法根据输入数据准确预测“黑盒子”的输出结果,无法精密控制“黑盒子”工作时的行为边界。这类似于我们知道如何掘开堰塞湖的堤坝让洪水泄出,却无法准确预测洪水会沿着怎样的路径向下游流淌。

OpenAI的超大规模预训练模型是深度学习诞生以来,AI在行为表现上最接近人类智慧的一个时期。但因为缺乏理论支持,科学家和工程师并不知道这种依靠海量参数来记忆和拟合人类知识特征的模仿游戏是不是通向通用人工智能(AGI)的正确道路,也很难从科学逻辑的角度准确判断未来的AI会不会一直都是人类的帮手,而不会发展成影响人类进步的负面技术。

03

最担忧ChatGPT的哪种前景?

我最担心类似技术被滥用在知识教育领域。

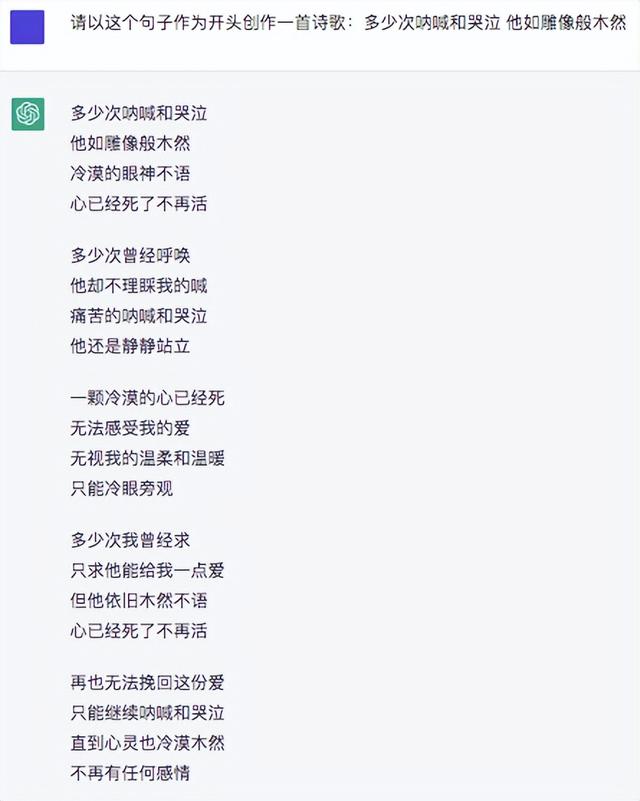

OpenAI在研发ChatGPT时,已经想尽方法,让AI在回答人类问题时尽量保持谦虚、谨慎,不要用戏谑性的风格回答问题,更不要给出与人类价值观不符的回答。这种谦虚、谨慎的态度,在ChatGPT的回答中几乎随处可见。例如,即便谈起自己的缺点,ChatGPT也从不遮遮掩掩,如下图所示。

但ChatGPT毕竟是建立在超大规模神经网络的基础上。人类通过强化学习对AI行为的监督,并不能完全杜绝AI在“不得已”的时候编造、杜撰答案。

这种编造和杜撰在有些领域可能是非常有用的。很多游戏开发者、科幻作者、美术工作者就经常用AI来启发自己的思路。但是,在知识教育领域,任由AI一本正经地“编造”知识型答案的前景是非常危险的!

想象一台内容创作成本接近于零,正确度80%左右,对非专业人士的迷惑程度接近100%的巨型机器,用超过人类作者千百万倍的产出速度接管所有百科全书编撰,回答所有知乎问题,负责孩子课外读物的生成,甚至直接被既懒又坏的教程编撰者、科普作者用来代笔……

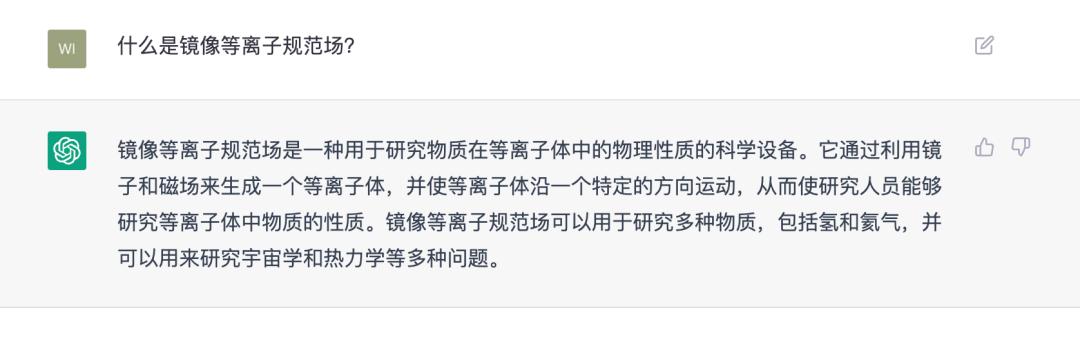

例如,以下是我用杜撰的学术概念“镜像等离子规范场”向ChatGPT提问的情形。看得出,对一个根本不存在的概念,AI是在不懂装懂地卖弄“学识”:

ChatGPT的模仿能力和文笔越好,这个未来风险就越恐怖。

未来三五年内几乎一定会发生的事情是:社交媒体、短视频平台上开始大量出现普通人不容易分辨,完全由AI创作的“灌水”内容。这些内容既可以极大丰富社交媒体的内容厚度,还可以根据AI对人类兴趣爱好的学习追踪,为不同人群打造更为庞大、牢固的“信息茧房”,并帮助内容平台更精准地投放广告、提高广告受益。

如果AI仅仅像这样被用于“信息茧房”的自动构建,我们还可以说这是一种不值得鼓励,但也不算很坏的商业行为。但是,假如批量的“灌水”内容进入每个孩子都在学习的网络百科全书里呢?加入这样的AI被用于辅导孩子学习呢?

根本问题在于,今天的AI生成理论没办法保证生成内容的逻辑正确与合理。我觉得,建立更完善的,由人类领域专家参与的AI训练过程,发展与正确性相关的增强学习算法,必然会成为未来的一个AI科研热点。就像我们讨论所有新一代技术的社会伦理问题一样,对AI在知识教育领域的“灌水”风险,大家一定要有正确的认知和足够的心理准备。

04

ChatGPT最好的应用场景是什么?

也许是,所有重复性的语言文字工作,以及所有启发性的艺术创作。

虽然担忧ChatGPT被滥用在知识教育领域,但我依然看好类似ChatGPT的高水平人机对话技术在其他一些真实应用场景里大放异彩。

首先,人类世界有太多重复性的语言文字工作,根本不需要复杂的逻辑思考或顶层决策判断。接听电话或处理邮件以帮助客户订旅馆、订餐的语言文字工作,根据固定格式把数据、信息填入合同、财报、市场分析报告、事实性新闻报道内的工作,在现有文字材料里提炼大纲、梳理要点的工作,将人类会议的实时文字记录提炼成会以简报,帮助人类撰写一些流程性、程式化文章的工作……这些工作领域,会很快出现一大批基于GPT-3或其他大模型的应用产品。上个月我在硅谷,就拜访了许多这一类AI创业的热点项目。

其次,无论是AI对话、AI写文章还是AI作画,大规模预训练模型固有的非确定性、发散性、天马行空的特点,恰好可以成为激发人类灵感的好帮手。需要创作广告文案或商业展示的市场工作,需要发散性地探索不同故事路线的电影编剧工作,需要极大丰富视觉感受的游戏场景设计工作……在这些工作领域,使用AI已经不是未来趋势,而是真真切切发生的事实了。

我熟悉的很多艺术设计师,插画师,广告创意顾问,游戏美术师,都已经在日常工作中,将AI当做辅助工具,坦然接受与AI协作的现实了。

05

如何看待AIGC的创业热潮?

AIGC(AI-generated content,字面意思是AI生产内容)的确火了,但AI和CS的专业人士必须保持冷静。

上个月我在硅谷拜访投资公司、科技公司、创业团队。科技圈里,几乎人人都在谈AIGC,似乎没有AIGC包装的创业项目就不是好项目,没有AIGC概念的科研就发不出好论文。

有件事给我一个“当头棒喝”:因为行业大佬的安排,我们有幸与OpenAI的两位联合创始人一起喝咖啡。期间,统领OpenAI科研的两位科学工程大牛用非常技术化、务实的心态谈他们的工作计划和技术思考。但,让我们无比诧异的是,两位创始人竟然不知道AIGC是什么意思!

仔细想来:从科技上开创AIGC这个新领域的OpenAI创始人,其实并不需要知道类似AIGC之类纯粹用来包装科技概念的新名词;他们要研究的是大模型结构、并行训练加速、神经网络优化等等具体科学与技术。这样的人才是真正的创建者和领航者。

在AIGC的概念下一拥而上,或创业,或投资,或把AIGC快速包装成应用产品的大多数,其实都是没能力决定科技大方向的跟风者。这世界上本来就跟风者多,领航者少,一点儿也不奇怪。

我只是简单期望所有跟风者在AIGC这个大舞台上,不要过于头脑发热,还是要多判断一下,自己构建的所谓“产品”,到底是有益于人类进步的,还是向已经碎片化的内容世界继续灌水或倾倒垃圾的。

制版编辑 | 小圭月